systemd のタイマーの実行予定を俯瞰したい

crontab と違って systemdは個別ファイルに実行予定を記載するため、全体の予定がわからない。

それを一覧で俯瞰したいなと思ったときどうするのか

list-timersを使う

sudo systemctl list-timers --all

list-timersコマンドで、次回実行予定の一覧が閲覧できて便利である。

できればクリックしたいレベル。

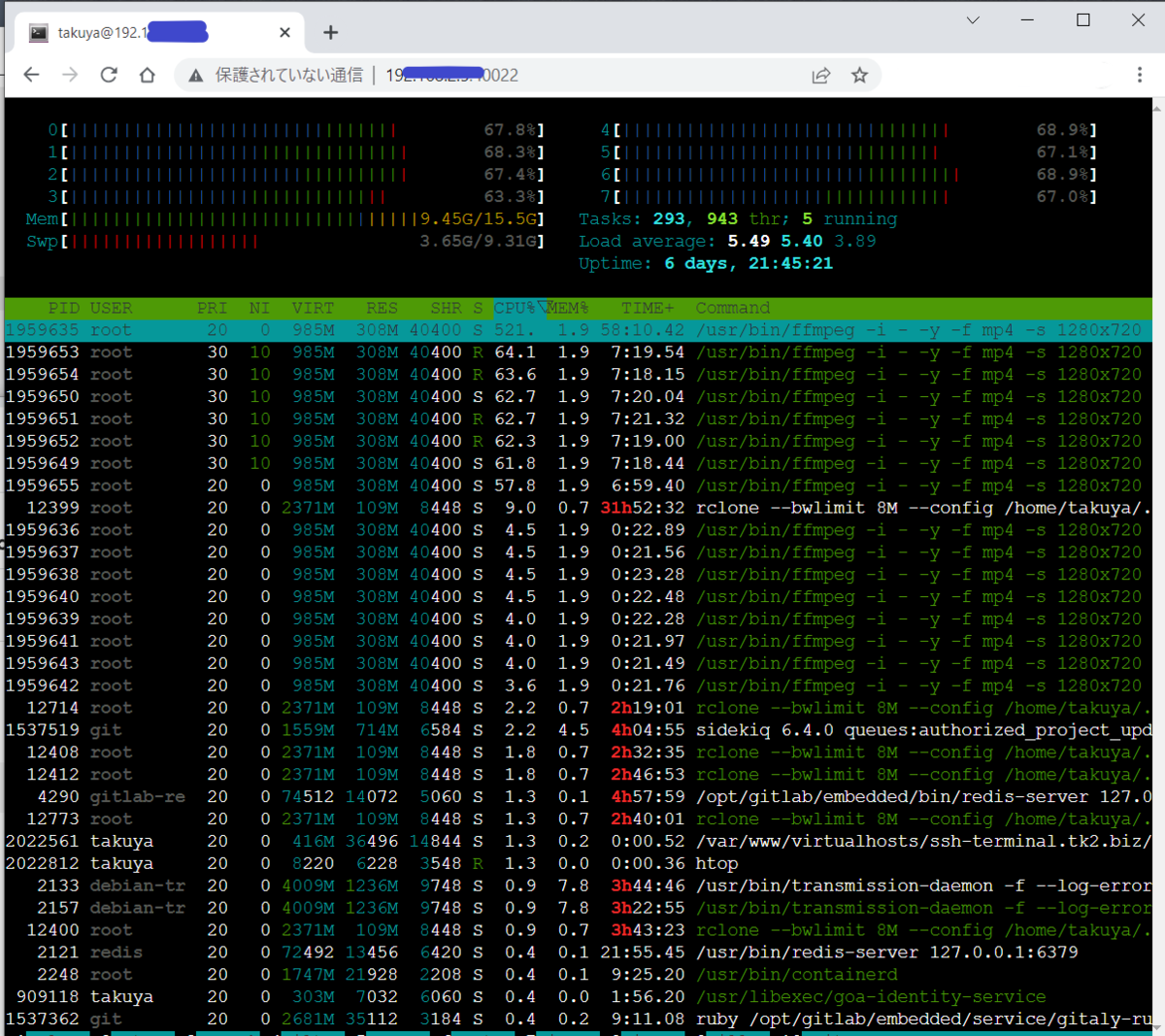

実行サンプル

takuya@livaz:~$ sudo systemctl list-timers --all NEXT LEFT LAST PASSED UNIT ACTIVATES Tue 2022-04-19 14:23:22 JST 57min left Tue 2022-04-19 08:02:50 JST 5h 23min ago ua-timer.timer ua-timer.service Tue 2022-04-19 17:02:36 JST 3h 36min left Mon 2022-04-18 17:02:36 JST 20h ago systemd-tmpfiles-clean.timer systemd-tmpfiles-clean.service Tue 2022-04-19 18:52:52 JST 5h 26min left Tue 2022-04-19 08:04:55 JST 5h 21min ago apt-daily.timer apt-daily.service Tue 2022-04-19 20:47:29 JST 7h left Tue 2022-04-19 08:02:54 JST 5h 23min ago fwupd-refresh.timer fwupd-refresh.service Wed 2022-04-20 00:00:00 JST 10h left Tue 2022-04-19 00:00:06 JST 13h ago logrotate.timer logrotate.service Wed 2022-04-20 00:00:00 JST 10h left Tue 2022-04-19 00:00:06 JST 13h ago man-db.timer man-db.service Wed 2022-04-20 05:06:05 JST 15h left Tue 2022-04-19 13:13:19 JST 12min ago motd-news.timer motd-news.service Wed 2022-04-20 06:38:29 JST 17h left Tue 2022-04-19 06:23:57 JST 7h ago apt-daily-upgrade.timer apt-daily-upgrade.service