apt search していると、時々見かける nox の意味は何なの?

たとえば、次のようなパッケージに使われている。

apt install vlc-nox apt install vim-nox

このように、nox と付くものがある。このsuffix(接尾子)は何の意味があるのか。

nox とは

nox とは no require X の略である。

なるほど

つまり、 X window を必要としないCLIでコマンドで動作するものですね。

raspi などで resize して expand file system と書かれているアレ

sudo gdisk /dev/whatyouwant

sudo gdisk /dev/whatyouwant

sudo partprobe

lsblk

この辺はよくわかってないけど、lsblk で確認する情報は、partprobeを回さないと、更新されない。

python のファイルをvim で編集しようとしていたら、すごく読みづらい。 カラーテーマが原因ですが、カラーテーマをpythonのためだけにぜんぶを変えるのもめんどくさい。

python のときだけ、他の言語と違う設定が必要。インデントや補完などpython は他の言語の設定と共通だと問題が多い。

vim を特定種類のファイルだけ設定を変えることが出来ないか。

vim には ftplugin ( file type plugin ) がビルトインされているのでソレを使うと簡単に設定ができる.

ファイルを作る。

mkdir -p .vim/ftplugin/ vim .vim/ftplugin/python.vim

このときに、python.vim としたらpython だけに適用される設定ファイルが書ける。

color elford set expandtab set autoindent

インデントとかをpython に合わせて書くことにする。

うん、見やすい。

vim で ft を見るときは、なにも値をセットせずに set すると現在の設定がecho される。

:set ft

素のvim を起動したいとき

vim -u /dev/null

なんでもいいから、ファイル名を指定したらいいよね。

vim -u NONE nvim -u NONE

これは、ファイルを指定してるだけなので、

nvim -u /dev/null

などとしたり、空っぽのファイルを読み込んだりしても同じことが得られる

touch a nvim -u a

新規ファイルや空ファイルなど、別の設定ファイルを使うテクニックは vim だけじゃなく curl などひろくコマンド一般で使えるテクニックですよね。知っておきたい老人の知恵ですね。

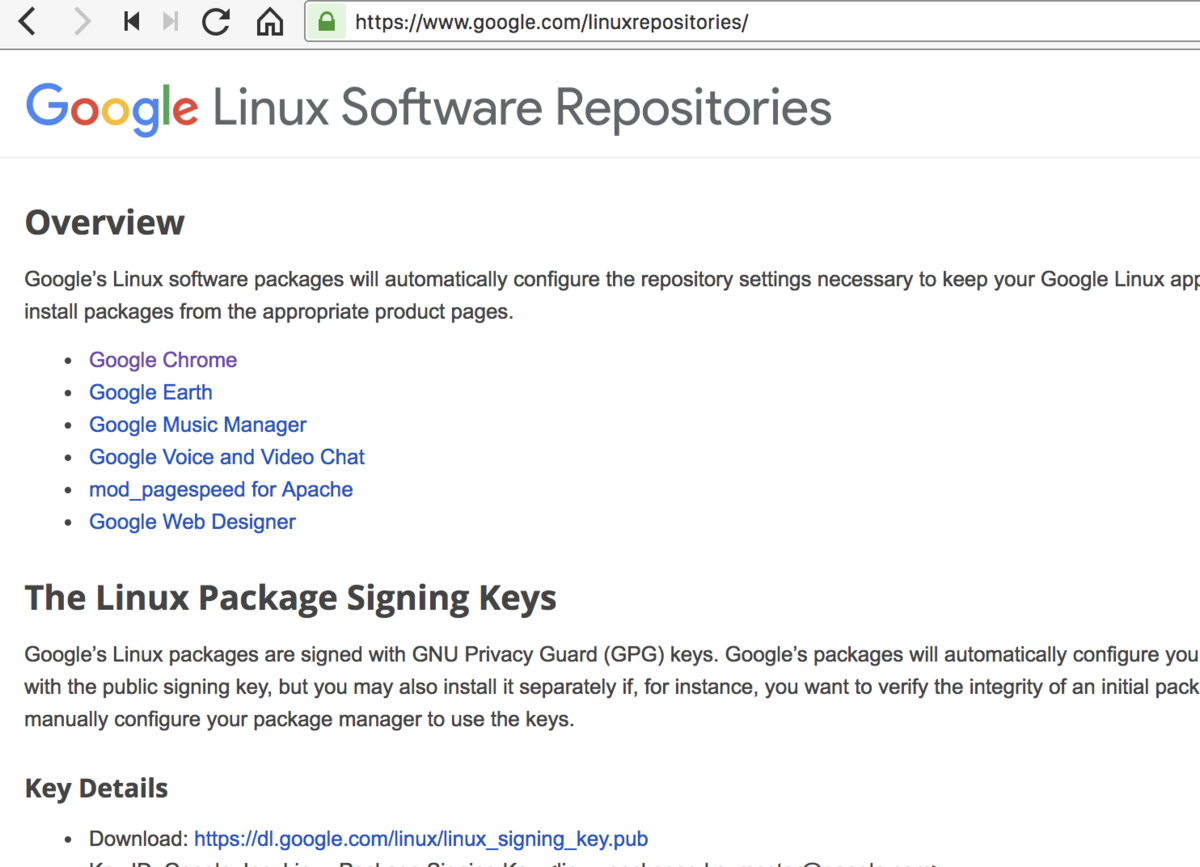

最新版のChromeは Google の配付サイトに用意されている。

wget -q -O - https://dl.google.com/linux/linux_signing_key.pub | sudo apt-key add - sudo apt update

もし、手作業でAPTのURLをいれるとき( /etc/apt/sources.list.d/google-chrome.list )を更新するか新規作成する。

echo 'deb [arch=amd64] http://dl.google.com/linux/chrome/deb/ stable main' > /etc/apt/sources.list.d/dl.google.com.list

apt update

apt search google-chrome-beta apt search google-chrome-unstable

takuya@~$ apt search google-chrom Sorting... Done Full Text Search... Done google-chrome-beta/stable 69.0.3497.57-1 amd64 The web browser from Google google-chrome-stable/stable 68.0.3440.106-1 amd64 The web browser from Google google-chrome-unstable/stable 70.0.3534.4-1 amd64 The web browser from Google

takuya@sakura:~$ apt show google-chrome-unstable Package: google-chrome-unstable Version: 70.0.3534.4-1 Priority: optional Section: web Maintainer: Chrome Linux Team <chromium-dev@chromium.org> Installed-Size: 204 MB Provides: www-browser Pre-Depends: dpkg (>= 1.14.0) Depends: ca-certificates, fonts-liberation, libappindicator3-1, libasound2 (>= 1.0.16), libatk-bridge2.0-0 (>= 2.5.3), libatk1.0-0 (>= 1.12.4), libc6 (>= 2.16), libcairo2 (>= 1.6.0), libcups2 (>= 1.4.0), libdbus-1-3 (>= 1.1.4), libexpat1 (>= 2.0.1), libgcc1 (>= 1:3.0), libgdk-pixbuf2.0-0 (>= 2.22.0), libglib2.0-0 (>= 2.31.8), libgtk-3-0 (>= 3.9.10), libnspr4 (>= 2:4.9-2~), libnss3 (>= 2:3.22), libpango-1.0-0 (>= 1.14.0), libpangocairo-1.0-0 (>= 1.14.0), libstdc++6 (>= 4.6), libuuid1 (>= 2.16), libx11-6 (>= 2:1.4.99.1), libx11-xcb1, libxcb1 (>= 1.6), libxcomposite1 (>= 1:0.3-1), libxcursor1 (>> 1.1.2), libxdamage1 (>= 1:1.1), libxext6, libxfixes3, libxi6 (>= 2:1.2.99.4), libxrandr2 (>= 2:1.2.99.3), libxrender1, libxss1, libxtst6, lsb-release, wget, xdg-utils (>= 1.0.2) Recommends: libu2f-udev Download-Size: 57.1 MB APT-Sources: http://dl.google.com/linux/chrome/deb stable/main amd64 Packages Description: The web browser from Google Google Chrome is a browser that combines a minimal design with sophisticated technology to make the web faster, safer, and easier.

ヘッドレスを使うためには。、いくつかのパッケージをいれる必要がある。

sudo apt-get install -y libappindicator1 fonts-liberation

headless-chrome は、xvfb にくらべて必要なモジュールも減ってるしすごく楽だよね。

headless chromeを使ってスクショをとるなら、フォントを持っていたほうがいい。

使ってみてわかったけど、フォントがないとスクショ取ると期待通りにならない。

sudo apt-get install msttcorefonts

この記事を書くために幾つかブログを見てたんだけど。

apt のソースが HTTP なのでセキュリティ的にやばい

などと嘘を書いているブログが散見されました。

apt-key で最初に「鍵」を登録しているので、HTTP通信で転送されたとして署名検証つまり改竄は検出できます。*1

HTTPSじゃないとセキュリティ基準が満たせない。

とかいてた人がいて、ちょっと何言ってるわからない。

HTTPはセキュリティ基準を満たせないとか、それでセキュリティを語れるんだと疑問を投げかけたいが人のブロクなので自重した。

そもそもapt-keyで何のために最初にキーを取得してんだろう。ほんの少し考えてほしかった。

https://dl-ssl.google.com/linux/chrome/deb/

杓子定規にセキュリティ基準を「満たせばいい」というのはどうなんだろうね。セキュリティ基準としても、ルールを守る側としても、どちらも思考停止していてるように感じた。

HTTPSで通信されちゃうと、何をインストールしてるか追跡不能になって、むしろめんどくさいと思うんだけど・・・

*1:この記述で理解できないひとはこの業界を引退したほうがいい

npm を入れた状況や入れ方にもよるんですけど、npm って ユーザーローカルなどを使えないよね。

まぁグローバルだから、当たり前と言われれば当たり前です。

takuya@~$ npm config --global get prefix /usr/local

わたしのmacOS の場合は /usr/local/ でした。

Linuxで、例えばグローバルに入れている場合。

curl -L https://npmjs.org/install.sh | sudo sh

いまどき、Linux のFHSに従って /usr/lib とか /usr/local/lib にいれる必要ってある?

macOS は ユーザー空間のホームディレクトリ空間で良くないか。

現在の設定を確認するには、これを使う。

npm config --global list

デフォルト設定を含めてすべて表示するときは、次のようにする。

npm config ls -l

このコマンドを見ると、次のようなおもしろそうな、ファイル名も見つかる。

prefix = "/usr/local" cache = "/Users/takuya/.npm" globalconfig = "/usr/local/etc/npmrc" globalignorefile = "/usr/local/etc/npmignore" init-module = "/Users/takuya/.npm-init.js" userconfig = "/Users/takuya/.npmrc"

npm には グローバルとローカルがあり、ローカルはフォルダごとに、グローバルはシステム全体。

システム全体をどう定義するか難しいところではあるが、「グローバル=ユーザー個人空間」と解釈して利用するほうがより現代的じゃないかなと感じた。

npm config set prefix

インストール先を変更するとができるのでそれを使うことにする。

わたしは、rubyのrbenv の gems を ~/.lib/ruby に突っ込んでいるので、そこを使うことにする。

npm config set prefix $( echo ~/.lib/node )

または、先程の config ls -l の結果に見える npmrc を使って

NPM_PREFIX=$( echo ~/.lib/node ) echo "prefix = $NPM_PREFIX" >> ~/.npmrc

などとしても良さそう。

takuya@Desktop$ npm config --global get prefix /Users/takuya/.lib/node

node コマンドが node_module をどこから探すかを知っておく必要がある。

Modules: CommonJS modules | Node.js v21.0.0 Documentation

node コマンドを起動したときに次の場所から探すようになっている。

つまり、 シンボリックリンクなどでぱぱっとやることで、npm コマンドだけでなく、 node コマンドからも簡単に変えることができる。

ln -sr ~/.lib/node/lib/node_modules/ ~/.node_modules

なぜグローバルのインストールを変えたほうがいいのでしょうか。

わたしは、sudoなどの権限管理とユーザー単位の管理が楽だからやりました。

パスワードを聞かれるのは不便だし、パーミッションの管理もめんどくさいのです。

/usr/lib のグローバルでのライブラリの共有は確かに便利だしディスクの容量節約になります。でも現代に置いてはDLL地獄にあるような、ライブラリの依存関係プロパティの地獄を味わうだけです。docker や openVZ のchrootアプローチも同じようなものです。

~/.npm はただのキャッシュ

~/.npm にnode_modulesがたくさんあります。それを見ると~/.npmにインストールされるように見えてしまいます。しかし .npm はキャッシュでそこにファイルはそのまま使うことはないようです。これの根拠は初期設定を見るとわかりました。

初期設定が次の箇所になっていました、

prefix = "/usr/local" cache = "/Users/takuya/.npm"

上は、私の設定場合です。設定を解釈すると、globalの npm のライブラリは /usr/local/node_modules にインストールされます。

~/.npm はキャッシュですね。

つまり、"/Users/takuya/.npm" にあるファイルはキャッシュです。ローカルインストール時に使われるようです。

私の npm i コマンドの実行時に取得した npm をキャッシュ保存していて、ここからローカルに配置するようです。開発ディレクトリを含むローカルインストールの高速化と負荷低減のためでしょうか、

windows です Windowsで npm を使うときです。今回紹介した設定を使ってフォルダを移動させる手法は、Windowsでとても役に立つのです。

nvm を利用しているときは、prefix を利用していると、nvm が使えないので、nvm を使おうとすると怒られます。

nvm のときの注意点

パスの記述を修正

仮想ファイルシステム的に、ダミーファイルを作ってそれをHDD(ブロック)デバイスとして扱う。

ダミーファイルを作ってコマンドの練習ができます。 fdisk / gdisk / gparted / cfdisk に、cryptsetup や dm-crypt とか、LVMの練習に、mount や mkfs や btrfsを試したり。

過去にLVMやKVM+qemu や windowsなどでもやりました。記事が散財して見つけにくかったので、まとめ直しました。

1GB程度のファイルを作る

dd if=/dev/zero of=out.1GB.img bs=1MiB count=200

実験するなら 1GBでも大きすぎるきもするので、200MiB程度で十分かも

dd if=/dev/zero of=out.1GB.img bs=1MiB count=200

sudo losetup -f my.img

いくつか、接続した結果がコレです。

takuya@:~$ sudo losetup NAME SIZELIMIT OFFSET AUTOCLEAR RO BACK-FILE DIO /dev/loop1 0 0 0 0 /home/takuya/out.2.img 0 /dev/loop2 0 0 0 0 /home/takuya/out.3.img 0 /dev/loop0 0 0 0 0 /home/takuya/out.1.img 0

詳細を見るのは次の方法でも大丈夫です。

takuya@:~$ sudo losetup -a /dev/loop1: [65025]:2104157 (/home/takuya/out.2.img) /dev/loop2: [65025]:2104158 (/home/takuya/out.3.img) /dev/loop0: [65025]:2103459 (/home/takuya/out.1.img)

ブロックデバイスの名前を指定して、接続を解除する

takuya@:~$ sudo losetup -d /dev/loop1

接続を解除した結果がこちら。

takuya@:~$ sudo losetup NAME SIZELIMIT OFFSET AUTOCLEAR RO BACK-FILE DIO /dev/loop2 0 0 0 0 /home/takuya/out.3.img 0 /dev/loop0 0 0 0 0 /home/takuya/out.1.img 0

一つずつ解除するのがめんどくさいんで -D / --detach-all でまとめて解除する・

takuya@:~$ sudo losetup -D

ぜんぶの接続が解除されました。

takuya@:~$ sudo losetup

パーティションを作らずに、シンプルボリューム*1でデバイスを作ってマウントする

めったに使わない btrfs でもこれで練習ができる。

takuya@:~$ sudo mkfs.btrfs /dev/loop1

btrfs-progs v4.7.3

See http://btrfs.wiki.kernel.org for more information.

Performing full device TRIM (200.00MiB) ...

Label: (null)

UUID:

Node size: 16384

Sector size: 4096

Filesystem size: 200.00MiB

Block group profiles:

Data: single 8.00MiB

Metadata: DUP 32.00MiB

System: DUP 8.00MiB

SSD detected: no

Incompat features: extref, skinny-metadata

Number of devices: 1

Devices:

ID SIZE PATH

1 200.00MiB /dev/loop1

マウントしてみる。

takuya@:~$ sudo mount -t btrfs /dev/loop1 ./mnt takuya@:~$ df ./mnt/ ファイルシス 1K-ブロック 使用 使用可 使用% マウント位置 /dev/loop1 204800 16640 121856 13% /home/takuya/mnt

これで、気にせずに実験ができるのでガンガンいこうぜ!

gdisk /dev/loop1

fdisk /dev/loop1

cfdisk /dev/loop1

パーティションを作った結果を確認した状態

takuya@:~$ lsblk NAME MAJ:MIN RM SIZE RO TYPE MOUNTPOINT loop0 7:0 0 200M 0 loop loop1 7:64 0 200M 0 loop └─loop1p1 7:65 0 199M 0 loop

/dev/loop1にパーティションを作ると loop1p1 が作られる。わかりやすい。

フォーマットするコマンドをあれこれ試してみると楽しいかもしれない

mkfs.bfs mkfs.btrfs mkfs.cramfs mkfs.exfat mkfs.ext2 mkfs.ext3 mkfs.ext4 mkfs.fat mkfs.minix mkfs.msdos mkfs.ntfs mkfs.vfat

NTFSの場合。

takuya@:~$ sudo mkfs.ntfs /dev/loop1p1 The partition start sector was not specified for /dev/loop1p1 and it could not be obtained automatically. It has been set to 0. The number of sectors per track was not specified for /dev/loop1p1 and it could not be obtained automatically. It has been set to 0. The number of heads was not specified for /dev/loop1p1 and it could not be obtained automatically. It has been set to 0. Cluster size has been automatically set to 4096 bytes. To boot from a device, Windows needs the 'partition start sector', the 'sectors per track' and the 'number of heads' to be set. Windows will not be able to boot from this device. Initializing device with zeroes: 100% - Done. Creating NTFS volume structures. mkntfs completed successfully. Have a nice day. takuya@:~$ sudo mount -t ntfs /dev/loop1p1 ./mnt

ディスクを取り扱ううえで、練習するコマンドもこの手法で練習できそうだ

ソフトRAIDとLVMの組み合わせなどめんどくさいこともぱぱっと試せそう。RAID on LVM や LVM on RAID とか。LUKS on LVMや LVM on LUKS とかもできそうですね。

chrootなども合わせて起動ディスクイメージ作成や、grub修正などもこの方法を知ってると楽。

ブロックデバイスをファイルとして作ってフォーマットをしたりパーティションを作ったり練習する事ができることがわかった。

Linux のブロックデバイスの扱いになれるには、アレコレの方法があると思うんだけど、私の知る限りでは、losetupとddを組み合わせるのが一番手軽だと思います。

まさか、フォーマットの練習のためだけに、VmwareやVirtualBox持ち出してパーティションを作る練習をするわけにも行かないし。手順も多く覚えることが多すぎてね。

ただし、ブロックデバイスとファイルの違いやファイルが何をしているかを知らないと混乱することになるので、完全な初心者にはおすすめできないのが難点。

fdisk は直接ファイルをいじれるし、mount も直接ファイルをマウントできたりするんだけど、いったんloopデバイスに取り付けちゃうと通常のSSD/HDDと変わらず扱いができるので迷わないですむし、覚えることも減る。

次回は、暗号化ディスクを作る練習をコレでやってみたいと思います。

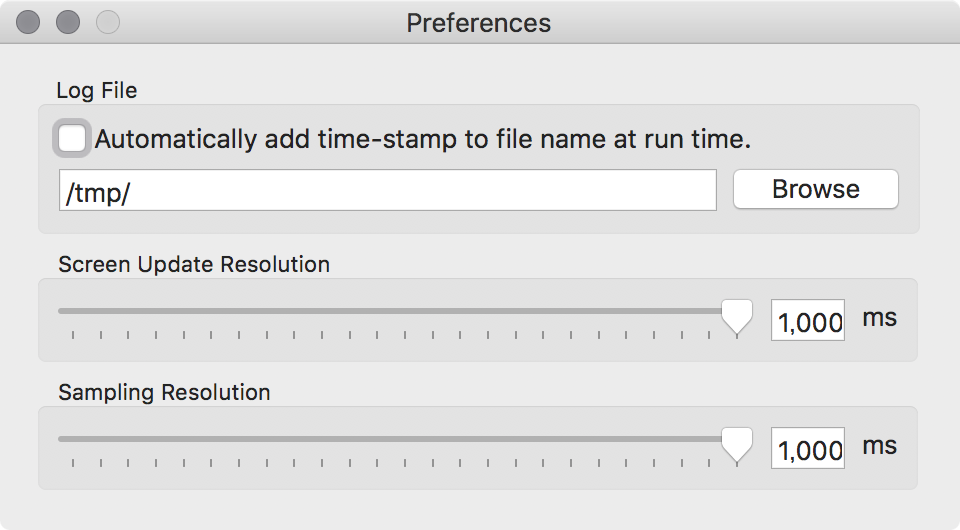

Intel® Power Gadget というプログラムが提供されている。

s-tui では見れなかったので、別のソフトウェアを探していて行き着いた。

しっかり表示されて嬉しい。

温度変化やCPUの変化、またコア数の利用率の変化を見ることができて楽しい。

ffmpeg で -threadオプションを使ったときや、スレッドプログラミングでGIL (global interpreter lock) を起こしてないかを見るのに使えそう。

取得感覚を指定できるんでしっかり見れる。

Linuxなら s-tui が手軽です。

ファイルのアーカイブとして使っている場合に、バックアップファイルが写真(メディア)の一覧に出てきて困る。

特定のフォルダが、写真(ギャラリー)の一覧に表示されないようにするには。ってずっと考えてた

とくに、ショートカットやリンクや設定を弄り回さなくても、ファイルを作るだけでいいとわかった。

cd /path/to/files touch .nomedia

これだけ。

上のように、 コンソールからやってもいい。他にもNextCloudのフォルダ画面からファイル作成でも良い。

Android のスマホなどではメジャー(?)な手法らしい。

https://github.com/nextcloud/gallery/wiki/How-to-ignore-folders

Steps to follow

- Switch to the "Files" app

- Navigate to the folder you want to hide

- Click on the "New" button sitting above the list of files

- Type ".nomedia" as the filename You're done. The folder will be ignored in Gallery from now on. You can also create that file in your mobile or desktop OS and sync it with your ownCloud.

nextcloud のバックアップにはひと手間が必要。occ コマンドにバックアップ用のサブコマンドが実装されていないので、手作業でバックアップする必要がある。

MySQLだとバックアップが面倒なので、SQLiteにすればよかったなと後悔してる。そんなにデータ入ってない。 メモリサイズの10%も超えること無いなら、メモリキャッシュが効くサイズだしSQLiteで十分だったわ。

定番のバックアップコマンドですね

mysqldump --single-transaction -h ${db_host} -u ${db_user} --password=${db_pass} ${db_name} 2>/dev/null | gzip > ${dump}

平文で入力するのがめんどくさそうなところですね。

バックアップスクリプトにMySQLのパスワードを書くのは嫌なので、require/include して再利用可能にする。 幸いなことに、nextcloud の config は単体で読み込み可能になっていてこれを使えばいい

ユーザーデータや設定ファイルのバックアップは個別にやる必要がありますが、私はめんどくさいので、フォルダごと転送することにした。

nextcloud は次のようなフォルダ構成になっているため、 nextcloud の最上位のフォルダに置けばいいとわかる。

. ├── backup.php ## 設置 ├── data ├── nextcloud │ ├── apps │ ├── config │ ├── console.php │ ├── core │ ├── cron.php │ ├── index.html │ ├── index.php │ ├── occ │ ├── settings │ ├── themes │ ├── updater │ └── version.php └── tmp

上記の例ではnextcloudのソースコードの入ったディレクトリの一つ上に設置した。

こうすると大丈夫。nextcloud のソースコードの入ったディレクトリの中にファイルを置くと一貫性(integrity)のチェックでエラーになると思う。

<?php /*** * * 2018-11-05 nextcloudのバックアップする * - MySQL をバックアップするスクリプト * - データ * - 稼働中のソース * @author takuya * @version 1.0 * */ ######################################### # READ nextcloud database configuration ######################################### $dir = dirname( __FILE__ ); $config_path = $dir. "/www-data/config/config.php"; if ( !file_exists($config_path ) ) { echo "config.php not found.\n"; exit; } include $config_path; $db_user = $CONFIG['dbuser']; $db_pass = $CONFIG['dbpassword']; $db_name = $CONFIG['dbname']; $db_host = $CONFIG['dbhost']; $nextcloud_path = "/var/www/virtualhosts/nextcloud.example.com/"; $dst_host = "takuya-oic-google-drive-epgrec"; #### set output filename $date = date("Y-m-d"); $dump = "nextcloud-${date}-mysqldump.sql.gz"; #### rclone config $rclone_conf = '/home/takuya/.config/rclone/rclone.conf'; ##################### ## build commands #################### $mysql_backup_cmd = "mysqldump --single-transaction -h ${db_host} -u ${db_user} --password=${db_pass} ${db_name} 2>/dev/null | gzip > ${dump} "; $mysql_rclone_cmd = "rclone --config ${rclone_conf} copy ${dump} ${dst_host}:backup/nextcloud.example.com/mysql_dump > /dev/null"; $mysql_remove_cmd = "rm ${dump}"; $data_rclone_cmd = "rclone --config ${rclone_conf} copy ${nextcloud_path} ${dst_host}:backup/nextcloud.example.com/nextcloud > /dev/null"; $cmds = array( $mysql_backup_cmd, $mysql_rclone_cmd, $mysql_remove_cmd, $data_rclone_cmd, ); chdir('/tmp'); // echo getcwd(); foreach ( $cmds as $cmd ) { $ret = shell_exec($cmd . "; echo $?" ); // echo $ret; if( $ret > 0 ){ echo "Error occurred in comamnd ( '$cmd' ) "; exit(); } }

実行権限は www-data か root で大丈夫。

sudo -u www-data php backup.php

rsync に変えても楽だと思う。sqliteならrsync で転送するだけで終わるんだけどなぁ。

だけどホストの証明書の取扱が面倒なので設定済みのrclone のconfig ファイルを使ったほうが楽でした。

https://docs.nextcloud.com/server/14/admin_manual/maintenance/restore.html

touch を使うと手っ取り早く実行できる。

touch -m -d '2018-11-06 19:51' sample.txt

access time だから a ですね。

touch -a -d '2018-11-06 19:51' sample.txt

日付のフォーマットは、割と何でもいい。Linux なので GNU Dateが解釈できたら割と何でも通る。

touch -a -d 'yesterday ' sample.txt touch -a -d ' -3 days ' sample.txt

とかでも許される。ただし日付はGNU/Linuxの話なので、他でも動くかは環境次第.

確認には stat コマンドが便利です。

takuya@:~$ stat sample.txt File: a Size: 0 Blocks: 0 IO Block: 4096 通常の空ファイル Device: fe01h/65025d Inode: 2102653 Links: 1 Access: (0664/-rw-rw-r--) Uid: ( 1000/ takuya) Gid: ( 1000/ takuya) Access: 2018-11-03 19:56:06.360940272 +0900 Modify: 2018-11-06 19:53:46.801494007 +0900 Change: 2018-11-06 19:56:06.357969865 +0900 Birth: -

私はやってませんでした。物理的に破壊すればいいと思ってたので。

中古HDDなんてヤフオクに出してもクレームの嵐だし。

それでも一定需要があるので「安全に・手軽に」読めなくすることで安心してHDDを出品できるようにすればいい。

HDDの物理破壊では危険です。物理破壊する業者が中間でデータを抜き去る可能性があります。

業務用PCの廃棄業者に丸投げするのも危険です。いくら契約で縛り付けようと、情報が一度流出してしまえば元も子もありません。

破棄するまえに、他社に移管する前で破壊しなくてはいけません。 しかし物理破壊するのはコストが高いです。

推奨されるのは、「データの暗号化」です。暗号化を複合する鍵がなければデータは読めません。iPhoneなどApple製品はこの方式です。

コマンドでデータを破棄する方法は物理破壊より時間はかかりますが、確実にデータを消去することができます。

物理破壊はコストも管理もずさんになるので全くおすすめしません。ところが世間では物理破壊がメインに採用されています。信じられない。

ふと思い出したんですよ。HDDって物理的に破壊する必要があるのかなって。

HDDって最近値下がりしてないし、まだまだ需要があるのかもって思い直しました。

HDDはシュレッダ(shred)コマンドにかけてデータを破壊するか、暗号化ディスクとして読めなければ十分ですよね。

暗号化はOS付属機能でかんたんに実現できるので、ここでは紹介しません。

今回は 「安全にデータを破壊する」方法です。

shred -v /dev/sdX ## または shred -vfz /dev/sdX

-v を忘れない-v は進捗状況を表示するオプションなので、これをわすれるといつ終わるのかが全くわからなくなる。必ずつけること

shred コマンドはランダムでファイルを書き換えていくのですごく時間がかかる。しかも3回やる。時間がかかる。本当にかかる。2TB消去するのに、数日とかかかる。

HDD の Write が 50MB/s 程度とすると、100MBに2秒 1000Mに20秒 1000*1000MBに 20,000秒 で、2.5日かかる

もし限界の150MB/s 程度が出たとしても、数回のランダムで埋め尽くすには 24時間程度じゃ足りない。

shred --verbose --random-source=/dev/urandom -n1 /dev/sbX

とにかく最低限で必要十分エントロピーを確保してなデータ消去ならコレで良い。

hdd を shred に掛ける時間を測定する。

4TB のHDDを消去するのに、さて何分掛かるでしょうか。

使ったのは、WD4TB WD4ERFXです、だいたいこれくらいの速度が出ます。

takuya@m75q-1:~$ sudo time shred -vfz /dev/sda [sudo] password for takuya: shred: /dev/sda: pass 1/4 (random)... shred: /dev/sda: pass 1/4 (random)...567MiB/3.7TiB 0%

4TBのShredに何時間かかったのか

user 12743.30 system 33:55:52

34時間です。結構かかりましたね。。。

通常使うなら暗号化ディスクで十分ですね。

まさか、ディスク完全消去のソフトウェアを購入したり、ドリルで穴を開けたりしないでしょ。

shred コマンドでデータを消せない場合があります。SSDです。こいつはいまのところ上書きで消せません。そのため暗号化が必須になります。

いまのところ、SSDをセキュアに完全消去する用事がないので。。。リンクだけ置いときます。

https://wiki.archlinux.org/index.php/Solid_state_drive/Memory_cell_clearing

安全に廃棄するにはドリルとかいうナンノコッチャな対策が世間を賑わせているので。このエントリが検索結果に上位に来るように書き直した。

こんなことを書いていると、ほんとうに思った通りの事件が起きて驚きました。

shred 時間測定したので追記。

takuya@:教科書$ find -type d -maxdepth 1 | xargs ll xargs: ll: そのようなファイルやディレクトリはありません

悲しい。Aliasはあくまで bashのエイリアスであり、シェル経由せずにfork するような場合には全く役に立たない。linux のコマンド実行の仕組みを知っていると別に不思議でもなんでもないんだけど初心者にはコレが不思議らしい。

sudo のときと同じように再帰的なalias展開を使えば、なんとかなる時がある。

alias xargs='xargs '

これをすれば 、動く

takuya@:教科書$ find -type d -maxdepth 1 | xargs ll ./2018-04-23-スキャンファイル: 合計 336K

alias の再帰的な展開に限界があるので、xargsにオプションつけたら、を渡せない

takuya@:教科書$ find -type d -maxdepth 1 | xargs -p ll xargs: ll: そのようなファイルやディレクトリはありません

あああ、、振り出しに戻る。。

find -type d -maxdepth 1 | xargs -I@ bash -c 'source ~/.bashrc;ll @'

find -type d -maxdepth 1 | xargs -I@ bash -ic 'll @'

コマンド文字のエスケープがあるので、ファイル名に「空白」 「&」などが挟まると面倒なことになる。

エイリアスが、bash_aliases変数にあることを利用して

echo "${BASH_ALIASES[ll]}"

ls -l -h

これをつかって

find -type d -maxdepth 1 | xargs -I@ ${BASH_ALIASES[ll]} @

などと出来なくもないが、良い解決策はないようです。

どうしても使いたいのであれば、 /usr/local/bin/xargs.sh を作って

引数のaliasを手作業で展開するしか無いと思う。めんどくさいわりに得られるものがないので作るのはしないけど。

#!/bin/bash # 引数を受け取ってalias を展開する #xargs に渡し直す

諦めましょう。

https://unix.stackexchange.com/questions/141367/have-xargs-use-alias-instead-of-binary

以前、rcloneについてのエントリを書きました。いまも便利に使っています。 rclone コマンドで google ドライブにデータを転送する(rcloneインストール方法と使い方) - それマグで!

root で実行すれば良いんですけど、指定したユーザーでないとアクセスが出来ないファイルのバックアップが出来なかったりするので不便です。( ~/.ssh/id_rsa など )

でも、設定ファイルをいっぱい書くのは管理が不便なのでめんどくさい。

config オプションを付ければ、設定を再利用できる。

rclone --config /home/takuya/.config/rclone/rclone.conf sync $SRC gdrive:$DST > /dev/null

config は、 ~/.config/rclone に保存されているので、そこを使えば設定を再利用できる。

rclone だと手軽にクラウドをバックアップサービスに使えるから便利ね。