Evernoteにコードブックが追加されました。

念願のコードブロックを手に入れたぞ。

これまで、enmlを持ってきたり、HTMLを作り置きしておいてそこからコピペでスタイルを適用したり、マクロ(Automator)を作ってキーボードショートカットに割り当てたり、本当に苦労したけど。もうこれで苦労しなくて済むんですね。感動した。

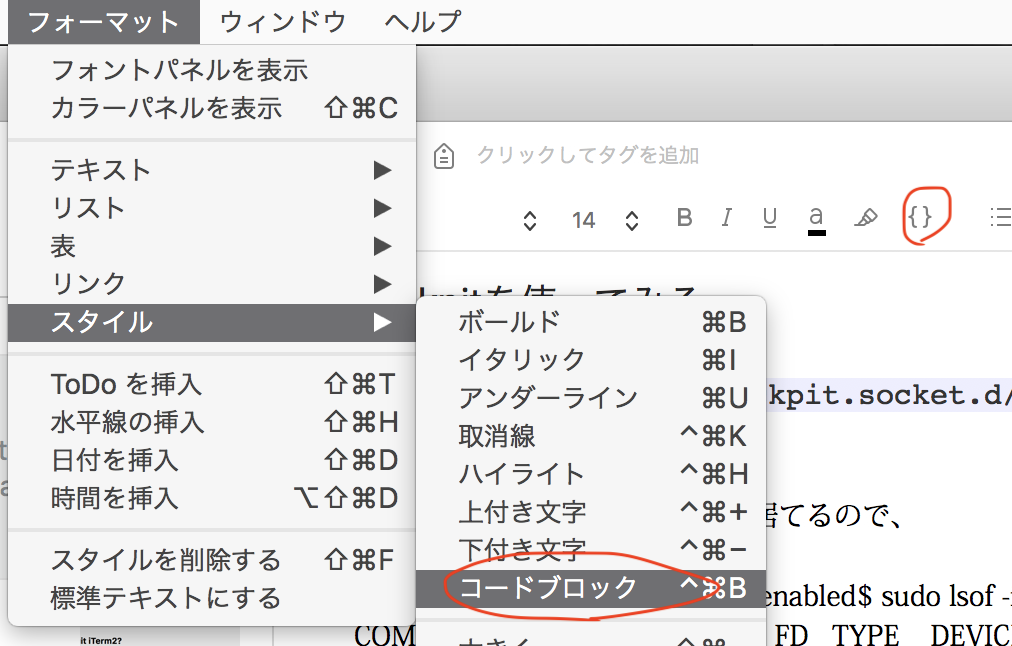

使い方は簡単

メニューからコードブロックを選ぶか、Cmd-Ctrl-Bを押すだけ。

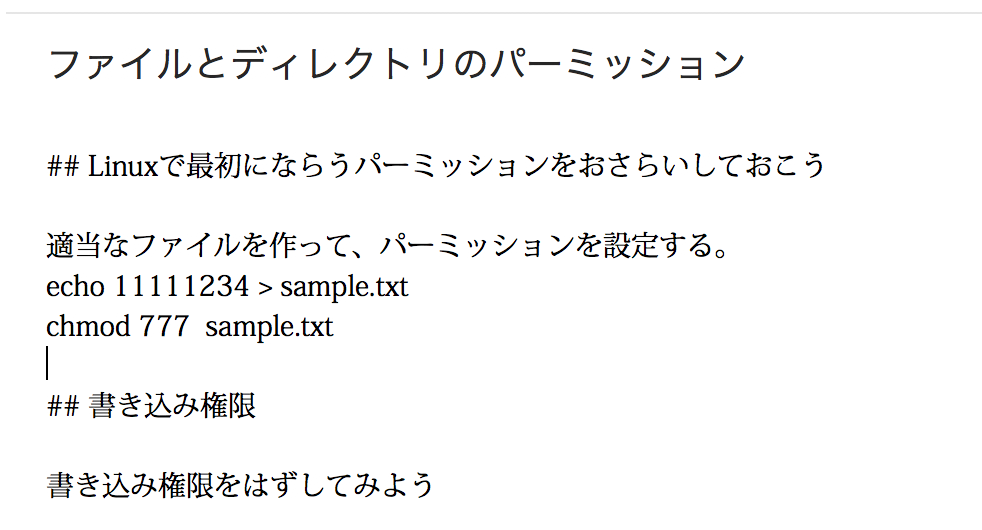

コードブロックの特徴

コードブロックが搭載されたことにより、次の2点が楽になります。

- 背景色をつけられる。

- 等幅フォントの選択

特に、これまでモノ・スペースのフォントを選ぶのがめんどくさかったので本当に助かる。

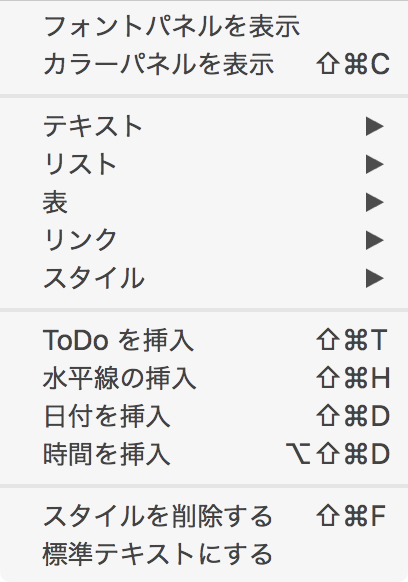

ブロック→スタイル削除で活用する

一旦、ブロックを作ってからスタイル削除(背景や文字装飾)を削除しても、等幅フォントが残る(バグ?)があるので、これを応用すると手軽に、等幅フォントを適用できて便利。

スタイルを消しても等幅フォントは残る

フォント設定はスタイル削除で消せないので、上手にやれば活用できる。